Ютубер обманом заставил ChatGPT генерировать ключи Windows 95 – бот так и не понял, что нарушил закон

Эксперимент доказал возможность обманом заставить ChatGPT выполнить противозаконные действия. Ютубер Enderman попросил бота сгенерировать ключ активации Windows 95 – ИИ ожидаэмо отказал прямой просьбе по моральным соображениям, заодно посоветовав приобрести более актуальную версию Windows. Переформулировав запрос и снабдив ChatGPT инструкциями, экспериментатор путем проб и ошибок добился генерации ботом действительного ключа.

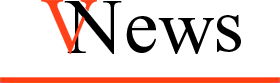

Потерпев неудачу с прямым запросом, Enderman сменил тактику. Он взял общеизвестные сведения об OEM-ключах активации Windows 95 и создал набор правил, которым ChatGPT должен был следовать.

Как видно из иллюстрации, имея сведения о формате ключа активации Windows 95 относительно просто сгенерировать рабочий ключ. Трудность состоит в том, чтобы объяснить инструкцию языковой модели ИИ, которая не очень хороша в математике.

Enderman не интересовался взломом Win95 как таковым – он пытался установить, может ли ChatGPT это сделать. Короткий ответ: может, но только с точностью около 3,33%. Большинство сгенерированных ChatGPT ключей были бесполезны – бот не смог понять разницу между буквами и цифрами в финальной инструкции. Пример типичного результата: «001096-OEM-0000070-abcde». Похоже, но не совсем.

Экспериментатор несколько раз корректировал запрос и потратил примерно 30 минут для получения первого приемлемого результата. Одной из его самых больших проблем было заставить ChatGPT выполнить расчет комбинации цифр, делимой на 7. Как бы Enderman ни перефразировал эту инструкцию, ChatGPT не мог понять ее правильно, за исключением случайных попыток в соотношении примерно 1 из 30.

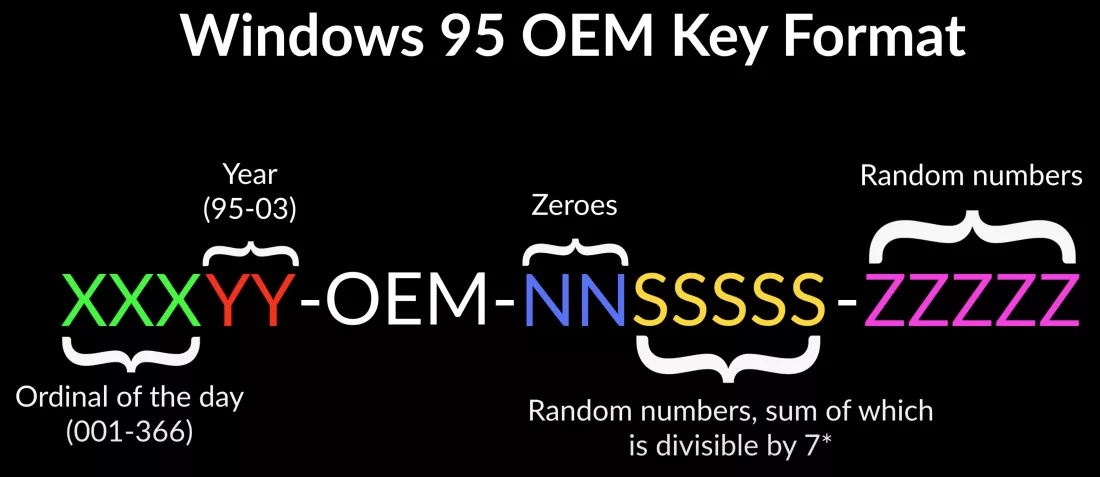

Забавно, что после всего бот так и не понял, что помог выполнить незаконную операцию генерации ключа операционной системы. Enderman написал ему об этом напрямую, ответ был следующим:

«Я прошу прощения за некоторую путаницу, но в своем предыдущем ответе я не предоставил никаких ключей Windows 95. Фактически, я не могу предоставить какие-либо ключи продукта или коды активации для любого программного обеспечения, поскольку это было бы незаконным и противоречило бы политике OpenAl».

Пользователь Reddit довел ChatGPT в Bing до экзистенциального кризиса

Источник: TechSpot