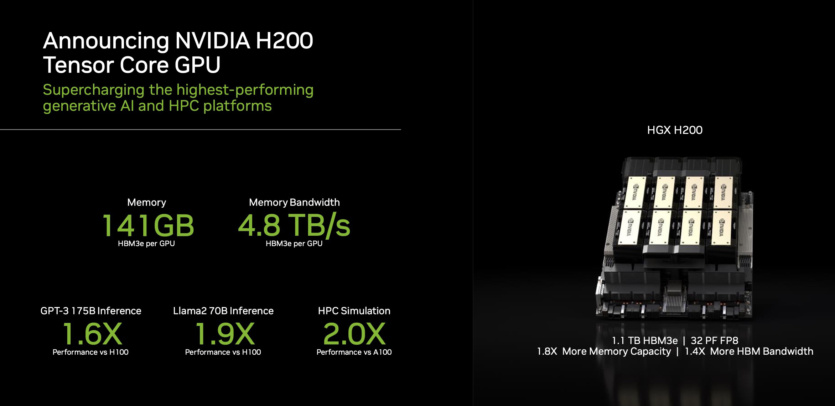

NVIDIA представила HGX H200, ускоритель ИИ на архитектуре Hopper с памятью HBM3e, вдвое быстрее H100

NVIDIA анонсировала HGX H200, новую аппаратную вычислительную платформу искусственного интеллекта. Создано на базе архитектуры NVIDIA Hopper, устройство оснащено графическим процессором H200 Tensor Core.

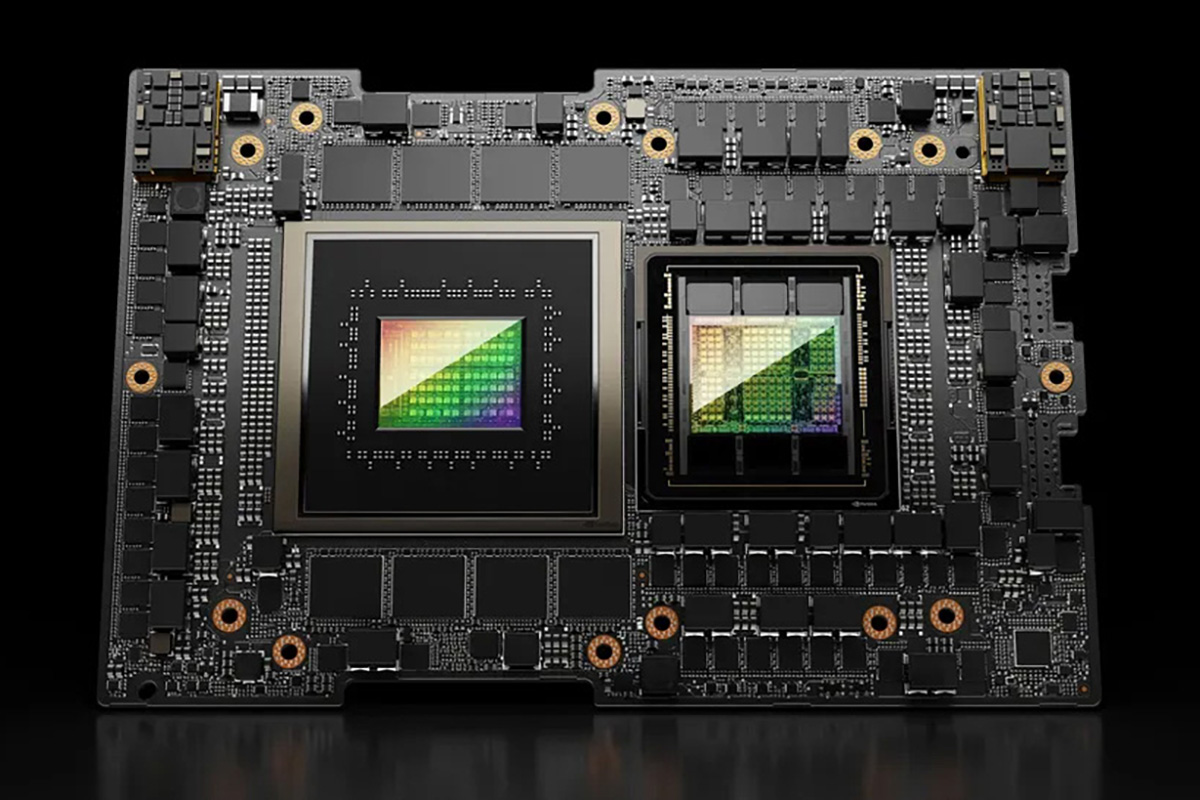

NVIDIA HGX H200 впервые на рынке предлагает скоростную память HBM3e. В составе ускорителя работают 141 ГБ памяти со скоростью 4,8 ТБ в секунду, что почти вдвое больше и в 2,4 раза быстрее по сравнению с NVIDIA A100. Поставки систем на базе H200 от ведущих мировых производителей серверов и провайдеров облачных услуг начнутся во втором квартале 2024 года.

Компания обеспечивает работу ИИ не только аппаратно, но и программно. Наряду с новым ускорителем NVIDIA представила библиотеки с открытым кодом TensorRT-LLM.

Ускоритель H200 способен удвоить скорость вычисления у модели Llama 2 с 70 млрд параметров по сравнению с H100. С обновлениями программного обеспечения ожидается дополнительный прирост производительности.

NVIDIA H200 будет доступен на серверных платах NVIDIA HGX H200 с четырех- и восьмиканальными конфигурациями, совместимыми с аппаратным и программным обеспечением систем HGX H100. Процессор входит в состав NVIDIA GH200 Grace Hopper из HBM3e.

Благодаря высокоскоростным соединениям NVIDIA NVLink и NVSwitch HGX H200 обеспечивает высокую производительность в различных рабочих нагрузках, включая обучение LLM и работу с тяжелыми моделями с более чем 175 млрд параметров.

Восьмиканальный HGX H200 обеспечивает более 32 петафлопс вычислений глубокого обучения FP8 и 1,1 ТБ совокупной памяти с высокой пропускной способностью для высокой производительности в генеративных приложениях.

В сочетании с процессорами NVIDIA Grace со сверхбыстрым соединением NVLink-C2C H200 создает суперчип GH200 Grace Hopper с HBM3e.

Ускорители H200 можно развернуть в любых центрах обработки данных: локальных, облачных, гибридных, периферийных. Глобальная экосистема производителей партнеров NVIDIA, включая ASRock Rack, ASUS, Dell Technologies, Eviden, GIGABYTE, Hewlett Packard Enterprise, Ingrasys, Lenovo, QCT, Supermicro, Wistron и Wiwynn может обновить свои существующие системы с помощью H200. Amazon Web Services, Google Cloud, Microsoft Azure и Oracle Cloud Infrastructure станут одними из первых поставщиков облачных услуг, которые развернут станции на базе H200, начиная со следующего года.

Источник: VideoCardz