Развитие ИИ вызвало рост рынка DRAM: NVIDIA и Intel заказали высокоскоростную память HBM (в 5 раз дороже обычной) у Samsung и SK hynix

Появление ChatGPT и аналогичных технологий открывает перед производителями памяти новые возможности для расширения бизнеса. Подобные системы обрабатывают большое количество данных и нуждаются в скоростных комплектующих для серверов. Более востребованной становится память с высокой пропускной способностью (HBM), всплеск заказов на которую с начала года уже получили Samsung Electronics и SK hynix.

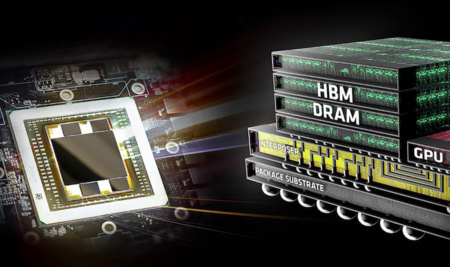

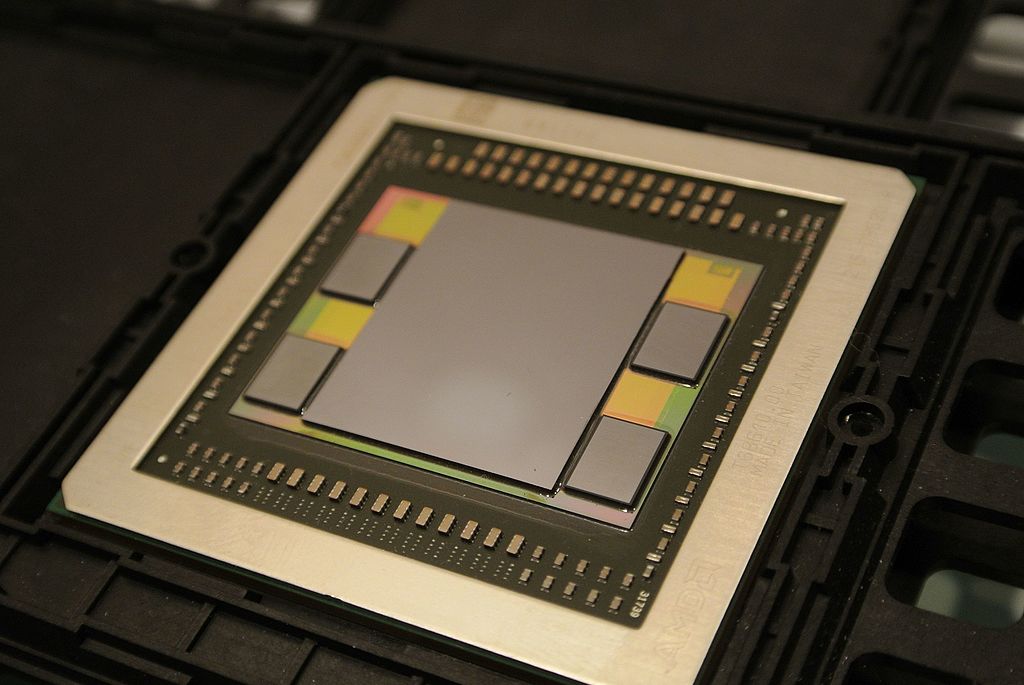

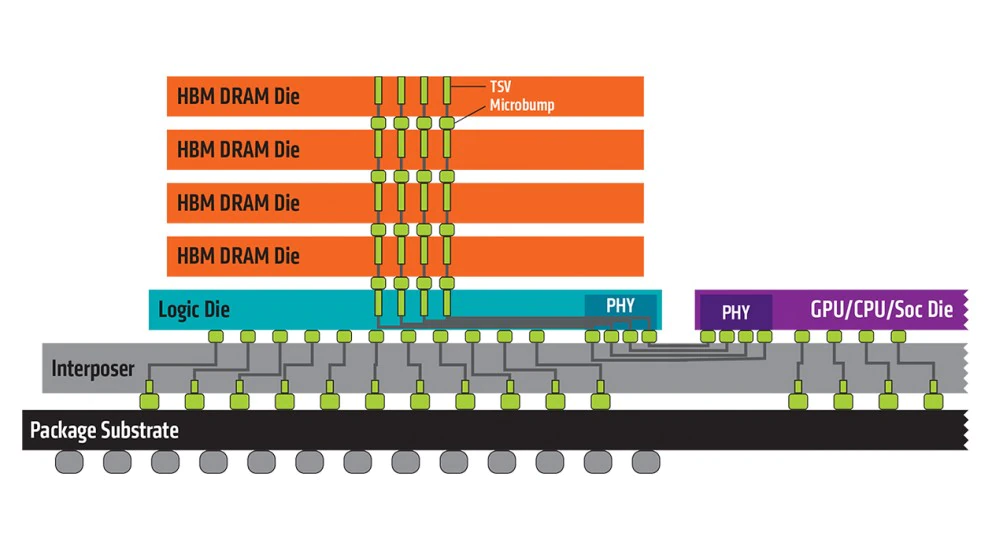

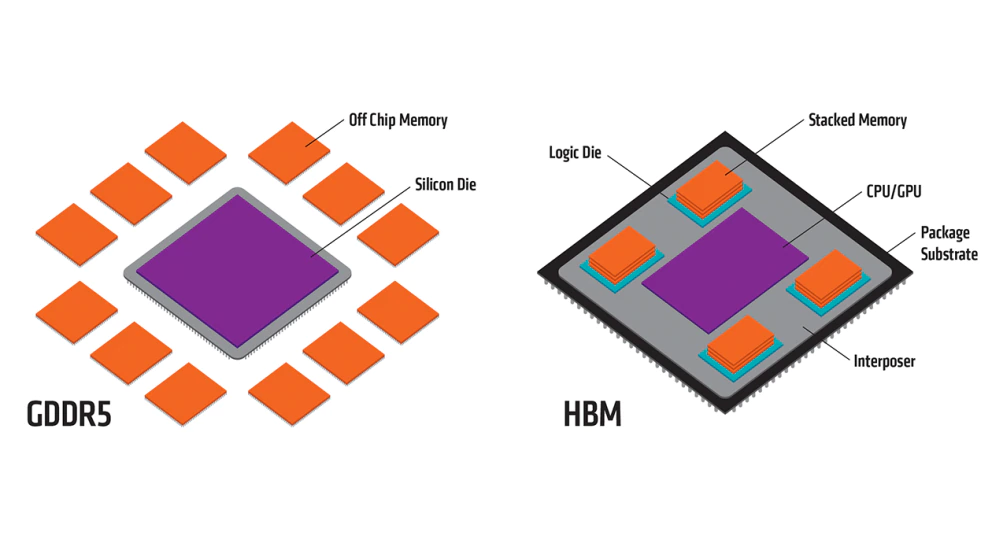

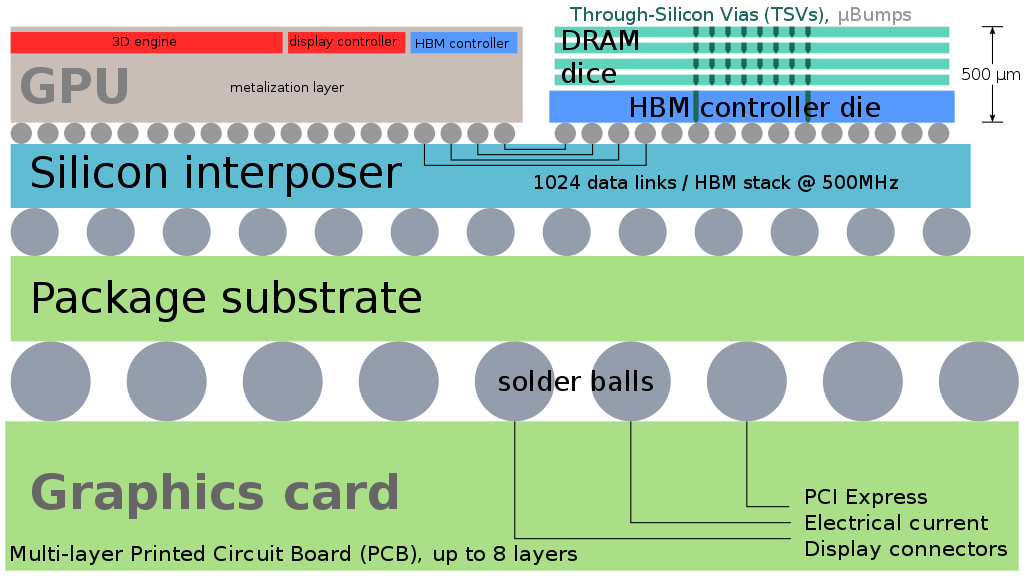

HBM значительно увеличивает скорость обработки данных по сравнению с другими типами DRAM за счет вертикального соединения нескольких чипов памяти. До сих пор, несмотря на отличные характеристики, HBM применялась меньше, чем у обычных DRAM. Это связано с тем, что средняя цена HBM в три раза выше, чем обічной DRAM. Производство HBM более сложное и технологичное. Однако развитие технологий искусственного интеллекта способно переломить ситуацию.

NVIDIA, крупнейший в мире производитель графических процессоров, используемых в вычислениях, обратилась к SK hynix с просьбой о поставке новейшего продукта – чипы HBM3. Intel, самый большой производитель процессоров для серверов, также активно работает над внедрением продуктов, оснащенных HBM3. Инсайдеры утверждают, что цена HBM3 увеличилась в пять раз по сравнению с наиболее производительной DRAM.

Ожидается, что рынок высокопроизводительных модулей памяти будет быстро расти, и между Samsung и hynix обострится конкуренция. Рынок HBM все еще находится в зачаточном состоянии, поскольку HBM начали всерьез внедряться ее в серверы для ИИ лишь начиная с 2022 года.

SK hynix лидирует на рынке HBM. Компания разработала HBM в сотрудничестве с AMD в 2013 году. Корейский производитель микросхем выпустил модули первого поколения (HBM), второго поколения (HBM2), третьего поколения (HBM2E) и четвертого поколения – HBM3, обеспечив себе долю рынка в 60-70%.

В феврале 2021 года Samsung в сотрудничестве с AMD разработала HBM-PIM, который объединяет чипы памяти и процессоры искусственного интеллекта в одно целое. Когда чип HBM-PIM работает с CPU и GPU, это значительно ускоряет вычисления. В феврале 2022 года SK hynix также представила решение на основе технологии PIM.

Эксперты прогнозируют, что в среднесрочной и долгосрочной перспективе разработка памяти для искусственного интеллекта, такой как HBM, произведет большие изменения в полупроводниковой промышленности. Негативной тенденцией может оказаться рост стоимости оборудования.

Micron анонсировала HBMnext — следующее поколение высокоскоростной памяти HBM

Источник: BusinessKorea