Яд для искусственного интеллекта: инструмент Nightshade добавляет в работы художников невидимые пиксели, которые повреждают генеративные модели

Пиксели «отравляют» генеративную модель в случае незаконного использования изображений и нарушают ее работу.

На фоне многочисленных судебных исков художников OpenAI, Meta, Google и Stability AI, команда Чикагского университета разработала собственный инструмент для борьбы за авторское право.

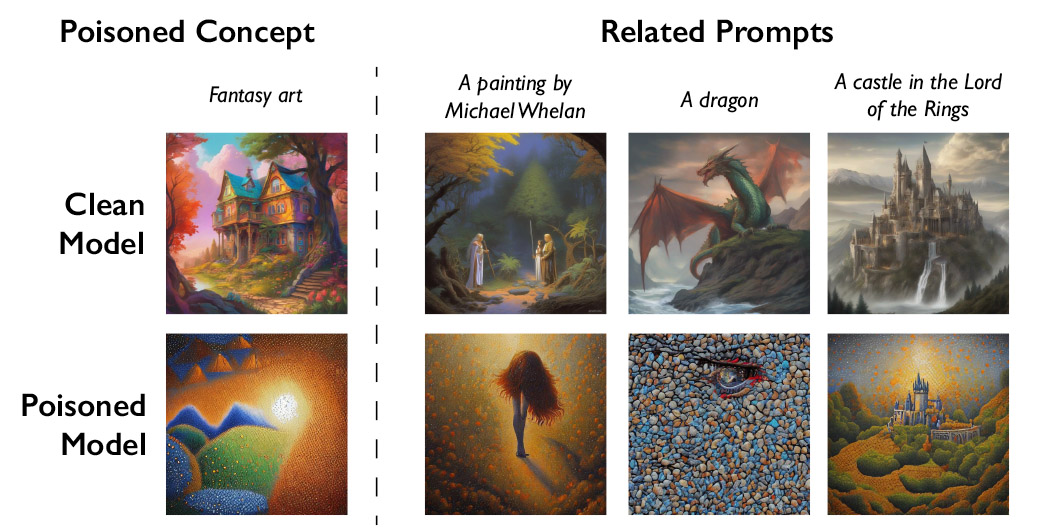

Nightshade позволяет художникам добавить на свои работы невидимые пиксели перед публикацией в интернете, и если «отравленное» изображение попадет в учебные данные такой модели, как DALL-E, Midjourney или Stable Diffusion, то вся их работа может нарушиться — собаки в результатах могут превратиться в кошек, а машины в коров и т.д.

Отравленные данные очень трудно удалить, поскольку это требует тщательного поиска и удаления каждого поврежденного образца.

Команда также разработала инструмент Glaze, позволяющий художникам «маскировать» свой личный стиль, чтобы предотвратить его использование компаниями искусственного интеллекта. Он работает подобно Nightshade: изменяя пиксели изображений тонкими способами, невидимыми для человеческого глаза, и манипулирует моделями машинного обучения, чтобы интерпретировать изображение как нечто отличное от того, что оно действительно показывает.

Nightshade в дальнейшем выпустят с открытым кодом, поэтому разработчики смогут усовершенствовать инструмент и создать собственные версии — от этого он станет мощнее, считают исследователи.

Инструмент протестировали на последних моделях Stable Diffusion и модели ИИ, которую обучили с нуля. Когда модель Stability AI получила 50 «отравленных» изображений собак, ее результаты стали выглядеть странно — имели слишком много конечностей или мультяшные лица.

Руководитель команды, профессор Бен Чжао, признает риски того, что технологию могут использовать злоумышленники, однако говорит, что им понадобятся «тысячи отравленных образцов, чтобы нанести реальный ущерб» большим и мощным моделям, обучающимся на миллиардах образцов данных.

Джунфен Янг, профессор информатики в Колумбийском университете, изучавший безопасность систем глубокого обучения и не участвовавший в работе, говорит, что Nightshade может заставить ИИ-компании проявлять больше уважения к художникам и побуждать к выплате роялти.

Источник: Engadget, MIT Technology Review